貝多芬:我要扼住命運的咽喉。那個年代沒有大數據、演算法。假如他活在今天呢?

大數據、演算法、人工智慧、網際網路、物聯網......科技的發展為人類生活帶來各種便利的同時,也在靜悄悄地決定著人們的生活軌跡和命運。

假設,如果中國有一年取消高考,用演算法根據歷年成績給每個應屆畢業生打分,然後大學根據這個分數決定是否錄取,錄取到什麼專業。

英國今年的中學畢業生對演算法的這種威力有切身體驗。

因為新冠疫情而取消了決定數萬名中學畢業生命運的考試,用電腦演算法( algorithm)給學生打分,讓機器根據學校往年的考試結果,經過一番運算,得出今年畢業生的成績。

決定命運的是高中畢業生的A-level 考試也決定了能否上大學,能上哪所大學。初中畢業,不再上學而開始求職謀生的,需要憑GCSE考試成績去找工作。如果準備繼續上學,日後申請大學時,這組成績也是重要參考數據。

除了這種“十字路口”式的人生關鍵節點,演算法在現代人生活中很多方面扮演著“無形之手”的角色,而我們未必知道。

BBC科技事務記者克雷頓(James Clayton)和克萊恩曼(Zoe Kleinman)梳理了幾個演算法左右命運的平台。

圖片版權GETTY IMAGES

社交媒體

從許多方面來看,社交媒體平台基本上就是龐然大物般的演算法。

它們根據你所提供的,以及來自其他各種渠道的數據,確定你的興趣、愛好、口味,然後為你推送更多它們認為你喜歡的內容。

這些數據包括你點的每一個“贊”,看的每一條訊息或視頻,點擊的每一個鏈接,都被記錄存檔。大部分應用軟體還會從你的上網習慣和特點,以及地理位置等信息提取更多數據,關於你的數據。這些數據用來判斷你喜歡什麼,哪些內容吸引你的眼球,能讓你在網上流連。

這個演算法對你了解越多,對你生活的影響力就越大。除了推送更多合你口味的內容,它自然還會用這個知識向你推銷產品。

社交媒體公司收集儲存的數據也被用來訂製個人化的廣告,定向投放,而且精準度高得令人咂舌。

當然,這類演算法也會犯很嚴重的錯誤,惹大禍。比如它發現極端的、刺激的、重口味的、充滿仇恨和煽動性的內容,在社交媒體上很吃香,比平淡普通的內容更賺眼球、點擊和轉發更多。所以有些人發現自己收到各種極端主義的、暴力的、仇恨的推送內容。

臉書針對民權問題做過一次內部審計,審計報告中明確提到,公司必須盡一切所能阻止它的演算法把用戶“驅趕到極端主義自我強化的迴音室裡去”。

演算法還有一個盲點,那就是對種族歧視和仇恨類產品不加分辨地推送,導致投訴甚至吃官司。

圖片版權GETTY IMAGES 如果搬家,你的房屋保險或汽車保險保費可能會變,因為不同郵編的風險和“索賠機率”不同

保險

保險公司需要評估風險,要做精算,無論是房產險、汽車險、壽險、醫療險,保費的多少依據這個評估結果來定。

許多人不知道的是,保險業很早就開始探索利用歷年積累儲存的數據來分析、預測未來;在電腦和演算法尚未普及的時候就開始了。

有了演算法,保險公司如虎添翼。

哈克尼斯(Timandra Harkness)是這方面專家,有一部關於大數據的專著(Big Data: Does Size Matter)。

有些顯而易見但人們通常不太在意的事,背後就有演算法的無形之手。

她舉了個例子,比如家庭住址的郵編就決定了你的保費高低,而你在這些問題上毫無發言權,完全被動。

你的房產或車保險保費在搬家後漲了還是降了,跟你個人沒有直接關係,而是跟這個地區的其他居民曾經,或者在多大程度上可能成為犯罪分子的受害者,或者遭遇水淹,或者出車禍,等等。

現在比較普遍的行車記錄儀,汽車上的“黑匣子”,可以用來記錄司機的駕車習慣,如果記錄顯示車主基本上是安全駕駛,即使其他指標都屬於高風險群體,他/她的汽車險保費也可能降低。

這是利用演算法制定個人化保險產品的一個例子。

保險行業的實質是風險分攤,人人交保費,需要的人從錢庫裡取。個人化的保險產品能否普及,或許還需要演算法來幫忙,確定這類新業務對保險公司有何利弊。

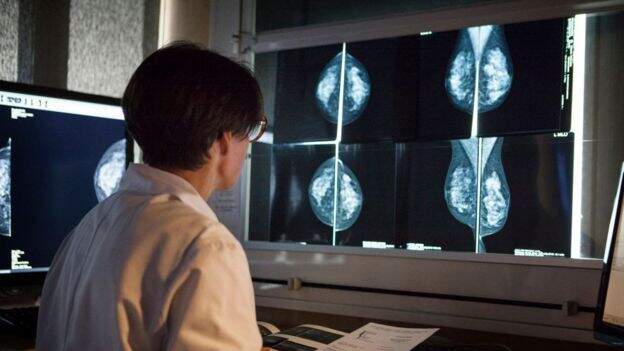

圖片版權GETTY IMAGES 看片子診斷病灶,比如乳癌,人工智慧比醫生肉眼更精準

醫療

人工智慧(AI)在疾病診斷方面的應用日益普及,有些地方AI甚至可以提出治療方案和療法建議。

2020年1月一項研究結果顯示,通過X光片子診斷乳癌,演算法的表現超過醫生。

其他例子也有,比如可以預測子宮癌患者生存率的工具,這個工具還能幫助確定治療方案。

倫敦大學學院(UCL)研發的人工智慧可以分辨出哪些病人最容易忘記就診預約,因此需要提醒服務。

海量數據是訓練人工智慧的必要前提。這就涉及到許多棘手的問題,包括病人隱私和個人數據保護。

2017年,英國信息委員會裁定,皇家自由醫院NHS信託沒有妥善保管病人數據,跟谷歌的人工智慧子公司DeepMind分享了160萬病人的數據。

圖片版權GETTY IMAGES

警務

大數據和機器學習對警察機構來說具有顛覆性的巨大潛力。

理論上,演算法具備了科幻作品中描述的那種“預測警務”(predictive policing)的功能,可以利用歷年刑事罪案的數據分析來確定警察資源的部署。

問題在於這種演算法有先天缺陷,容易產生演算法偏見,甚至形成演算法種族歧視。

科技智庫WebRoots Democracy專家喬杜裡(Areeq Chowdhury)解釋說,這就跟演算法確定考試分數類似,實際上是根據別人過往的學業表現來給你打分,有什麼道理?

他說,根據演算法,一個特定社區很可能被不成比例地突出和強調。

國防和安全智庫RUSI今年稍早發表了一份報告,闡述演算法在警務實踐中的應用。

報告提出一些需要關注的問題,包括沒有全國統一的準則,也沒有影響評估機制。

另一個需要深入研究的問題是演算法如何放大、加劇種族主義傾向。

警務部門已經在使用的人臉識辨技術受到批評,矛頭集中在用於機器學習的數據庫是否會導致演算法種族主義。

比如,用於人臉識別的攝像機識別白人更準確,是否因為它們背後的數據庫裡白人的面部數據更多?

這方面,數據是否足夠多,足夠多元化,就至關重要。

喬杜裡說,最應該避免的是因為演算法誤判而錯抓無辜。